Expertise Data & AI sur AWS

Ippon Technologies construit vos plateformes de données AWS à l’état de l’art depuis 2016.

Nos convictions ? Simplicité et efficacité. Nos outils ? L’usage de solutions serverless en application du Well Architected Framework.

L'histoire du MLOps sur AWS, Chems Eddine Nabti

Bénéficiez de la puissance du Cloud AWS pour vos projets data & AI

Comme Orange Bank,Engie Digital et bien d’autres, vous pouvez faire confiance à nos experts Data & AI pour vous accompagner dans la mise en place de vos cas d’usages data dans le cloud AWS.

En partant de la stratégie data et en travaillant main dans la main avec vos équipes métiers et IT , nos 70 data architects, engineers et scientists collaborent avec vous pour vous aider à exploiter toutes les possibilités offertes par les services Data & AI proposés par AWS. En 2018, suite à un audit externe exigeant, nous avons obtenu la Data & Analytics Competency d’AWS. Mais ce n’est que le début du chemin et nos consultants passionnés restent à l'affût de toutes les nouvelles fonctionnalités qui ne cessent de voir le jour.

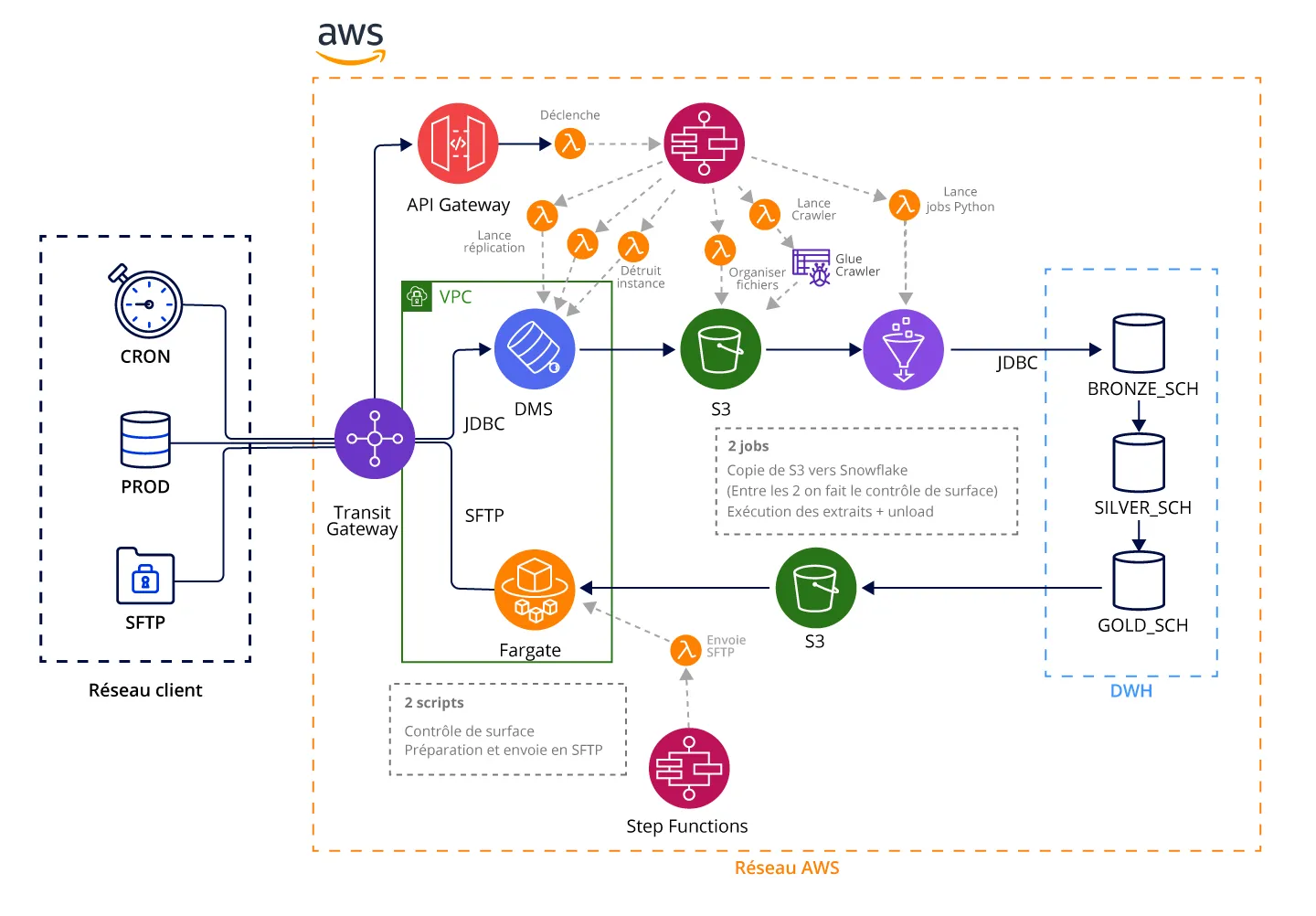

Voici quelques exemples d’architectures éprouvées chez nos clients :

- Pour les architectures événementielles, nous recommandons l’utilisation de Lambda Functions orchestrées par le moteur à état Step Functions et découplées grâce à la base DynamoDB.

- Pour les applications analytiques à des fins de reporting, nous nous appuyons sur le triptyque S3, Glue et Athena qui autorise une grande variété transformations et s’appuie sur le Glue Catalog pour référencer les données disponibles.

- Pour du reporting complexe, la puissance de Redshift, qui offre dorénavant une capacité serverless, permet de brancher les meilleurs outils de data visualisation du marché en mode Live Query.

- Pour les workloads plus exigeantes, nous nous appuyons sur la puissance d’EMR grâce à nos data engineers experts en Spark.

Besoin de vous transformer ?

Rencontrons-nousNotre méthode éprouvée : Data Discovery to Value Delivery

Notre méthodologie Data Discovery to Value Delivery se déroule en 3 étapes :

- Étape #1 - Data Discovery : nous travaillons avec vos équipes métiers pour identifier les cas d’utilisation, avec vos data owners pour comprendre vos sources de données et vos experts techniques pour définir l’architecture de la plateforme de données.

- Étape #2 - Set up : nous déployons et documentons la plateforme de données en infrastructure-as-code et en étroite collaboration avec vos équipes techniques.

- Étape #3 - Value Delivery : nous réalisons, en méthode agile, vos use cases priorisés pendant la phase de Discovery.

Cette méthodologie est tout à fait compatible avec le programme MAP d’AWS.

Un de nos clients du monde de l’assurance nous a fait confiance pour améliorer la performance de son calcul d’inventaire.

En déportant les calculs complexes dans le Cloud AWS, nous avons pu réduire les temps de traitement de 48h initialement à moins de 2h à la cible.

Exemple d’architecture simple pour optimiser une chaîne de calcul d’inventaires dans le monde de l’assurance :

MISE EN PLACE D’UNE PLATEFORME ML

Pour une noébanque, nous avons élaboré une approche complète pour aider notre client à utiliser toute la puissance d’Amazon SageMaker :

- Réalisation d’un POC, pour d'évaluer la faisabilité des projets avant de passer à l'étape de la mise en production de modèles.

- Mise en production des modèles sur SageMaker en utilisant des outils de pointe tels que SageMaker Pipelines et SageMaker Model Monitor. Nos équipes d'experts travaillent en étroite collaboration avec notre client pour garantir des résultats optimaux.

- Audit de bonnes pratiques pour aider les data scientists à optimiser l’utilisation de SageMaker et à garantir une qualité opérationnelle.

Nos derniers contenus Data & AI

CaRool

Ippon a accompagné CaRool dans le développement de sa solution innovante de Machine Learning Serverless.

Lire la success story

Orchestrer vos jobs Spark avec Amazon EMR et Airflow

Découvrez comment articuler les avantages d’un orchestrateur autour de ses jobs Spark dans AWS, et en quoi est-ce un game changer ?

Lire l'articleMLOps : L’IA doit basculer dans l’ère industrielle

Alors que l’IA a commencé à démontrer son ROI sur de multiples cas d’usage, l’heure est maintenant venue de passer à l’échelle. Il faut industrialiser son déploiement et mettre en place une approche de gestion du cycle de vie des IA.

Lire l'article